Por Ryan F. Mandelbaum

Esta década ha marcado no solo un punto de inflexión en la historia de la física, sino varios.

La década de 2010 ha sido una década increíble para el conocimiento, pero lo más importante es que los descubrimientos de esta década —y la rotunda falta de ellos— han cambiado la forma de pensar de los físicos en sus respectivos campos. La física de partículas y la astrofísica han entrado en una época nueva que cambiará la forma en que los investigadores hacen ciencia. Las nuevas tecnologías basadas en la mecánica cuántica podrían marcar un cambio importante en la informática, la ciencia de los materiales y la forma en que manejamos la energía.

“Parece que estamos en medio de un cambio de paradigma”, dijo a Gizmodo Natalia Toro, profesora asociada de física de partículas y astrofísica en la Universidad de Stanford. “Todavía no está claro a dónde vamos, pero creo que dentro de 50 años, la última década será recordada como el comienzo de un cambio importante en nuestra comprensión de la física”.

Encontrando las cosas más pequeñas

Esta década trajo cambios radicales en la forma de entender de los científicos tanto lo grande como lo más pequeño. Quizás lo más notable es que los científicos del Gran Colisionador de Hadrones, el gran acelerador de partículas que hay Ginebra, descubrieron pruebas de la existencia del bosón de Higgs, la última partícula descrita por la teoría central de la física de partículas, denominada Modelo Estándar.

Antes de 1964, algunas teorías funcionaban bastante bien para describir el universo, pero tenían un problema: predecían que ciertas partículas que los físicos ya sabían que tenían masa deberían no tenerla. Más tarde, seis científicos (el más famoso era Peter Higgs), publicaron tres papers que solucionaban ese problema, detallando un mecanismo por el cual la masa podía convertirse en unas partículas que tuviesen fuerza, llamadas bosones de gauge, por lo que esas teorías que explicaban el universo aún serían correctas. Ese mecanismo requería la existencia de otra partícula, llamada bosón de Higgs. A pesar de buscarlo, nunca consiguieron dar con el bosón de Higgs, hasta esta década.

El Gran Colisionador de Hadrones (LHC, por sus siglas en inglés) del CERN, el experimento científico más grande jamás construido, abrió sus puertas en 2008. El 4 de julio de 2012, investigadores de todo el mundo abarrotaron auditorios y salas de conferencias para escuchar a los investigadores del LHC anunciar que habían descubierto pruebas del bosón de Higgs. Muchos dijeron que se habían encontrado todas las partículas que había predicho el Modelo Estándar, y que por lo tanto, el modelo estaba completo… ¿o quizás no?

Foto: Robert Hradil, Monika Majer/ProStudio22.ch

“Decir que hemos completado el Modelo Estándar implica que hemos acabado”, dijo a Gizmodo Patty McBride, distinguida científica del Laboratorio Nacional Fermi. “Y no lo hemos hecho”. Muchos misterios y, de hecho, alrededor del 96% de las cosas en el universo, aún no se pueden explicar por el Modelo Estándar.

El Gran Colisionador de Hadrones ha estado inquietantemente tranquilo desde 2012. Desde entonces se han obtenido muchos resultados interesantes que prueban el Modelo Estándar, pero no se han encontrado nuevas partículas después del bosón de Higgs. Los físicos esperaban que el CERN descubriera pruebas de otras partículas, como las supercompañeras. Se predijo que estas partículas proporcionarían simultáneamente una explicación de por qué la gravedad es mucho más débil que las otras fuerzas (piensa por ejemplo que toda la gravedad de la Tierra es incapaz de evitar que un imán de nevera atraiga un clip de metal) y podrían ser la verdadera identidad de la materia oscura, el misterioso material que parece formar el andamiaje del universo que no hemos sido capaces de observar directamente. Y aunque todavía quedan muchos datos del LHC para analizar y a pesar de que el LHC podrá aumentar dentro de poco la tasa de colisiones que es capaz de hacer, los científicos comienzan a preguntarse si alguna vez encontrarán pruebas de estas partículas.

Pero la falta de descubrimientos algún día podría verse como un punto de inflexión en la historia de la física. Los físicos de partículas han comenzado a buscar partículas de otras maneras, como mediante experimentos de alta precisión que buscan probar diferentes predicciones del Modelo Estándar a través de desviaciones pequeñas pero estadísticamente significativas de lo que predice esta teoría, en lugar utilizar supercolisionadores de alta energía. También se alienta a los teóricos a buscar explicaciones más originales para explicar cosas como la materia oscura.

“Es cada vez más difícil tecnológicamente llevar a los aceleradores de partículas a energías más altas para buscar nuevas partículas”, dijo a Gizmodo Josh Frieman, profesor del departamento de astronomía y astrofísica de la Universidad de Chicago. “La comunidad de la física de partículas se ha dado cuenta de que necesitamos una diversidad de enfoques… Será todo un desafío. Cuando tienes un problema desafiante como éste, hay que usar todas las herramientas que tienes en tu kit, porque las nuevas teorías físicas están siendo poco atrevidas”.

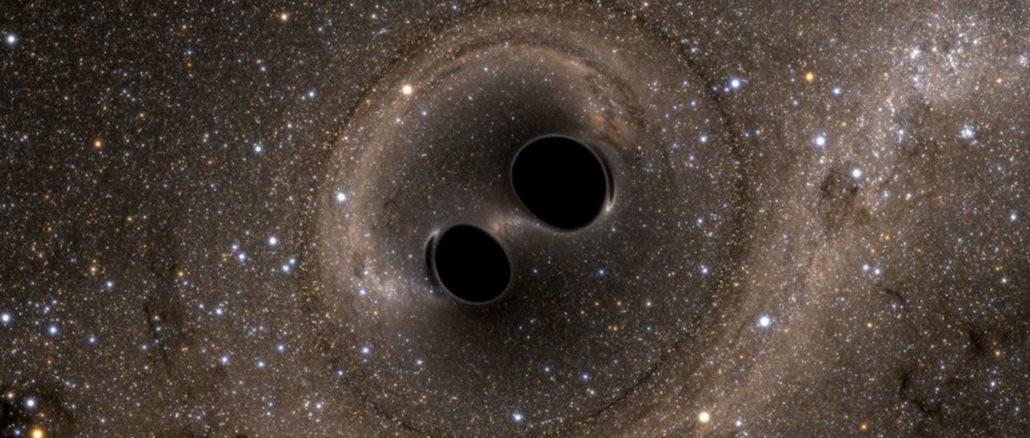

Rompiendo el espacio-tiempo

Esta década también revolucionó la física a gran escala. Hace más de un siglo, la teoría de la relatividad general de Albert Einstein predijo que los eventos de alta energía podrían emitir perturbaciones en el espacio-tiempo que viajen a la velocidad de la luz, llamadas ondas gravitacionales. Los científicos buscaron durante mucho tiempo las ondas gravitacionales producidas por una supernova o por una colisión entre agujeros negros binarios. Empezaron a aparecer pruebas indirectas de las ondas con el primer descubrimiento de un púlsar binario (una especie de estrella de neutrones giratoria). Después de varios años, los científicos se dieron cuenta de que su periodo orbital estaba disminuyendo de la misma manera que había predicho la teoría de la relatividad general, que defendía que dicho sistema perdería energía debido a la producción de ondas gravitacionales. Pero no encontraron pruebas materiales de ello.

Bueno, hasta esta década. El 14 de septiembre de 2015, a las 5:51 am ET detectaron las oscilaciones creadas por la fusión de dos agujeros negros a 1.300 millones de años luz de distancia, y que emitieron sus ondas gravitacionales en dirección a la Tierra.

Después de esto, se produjeron más observaciones, pero tal vez el descubrimiento más innovador se produjo en 2017, cuando varios detectores midieron ondas gravitacionales en el mismo instante en que los telescopios de todo el mundo consiguieron detectar varios destellos de ondas ultravioleta, de radio, infrarrojas, y radiaciones ópticas que provenían del mismo punto en el cielo. Esta explosión de energía fue el resultado de la colisión de dos estrellas de neutrones, una especie de cadáveres estelares del tamaño de una ciudad. Este evento tan singular permitió a los científicos aprender cosas sobre el origen de algunos de los elementos más pesados de la tabla periódica y que algún día podría ser útil para explicar porque el universo está en un proceso deaceleración.

Este descubrimiento supuso un cambio de paradigma y fue un sello distintivo de la astronomía multimensajero, un tipo de astronomía donde los científicos usan tanto ondas de luz como la detección de otras partículas u ondas para poder observar una fuente. Los telescopios en un primer momento solo usaban luz visible, más tarde fueron otras longitudes de onda o radiacioneselectromagnéticas, como los rayos X o las ondas de radio, y ahora algunosobservatorios pueden incluir datos espaciales provenientes de partículas como los neutrinos o las ondas gravitacionales.

“Esta es la edad de oro de la astronomía multimensajero”, dijo a Gizmodo Peter Galison, profesor de física en Harvard.

El campo de los agujeros negros también vivió un momento decisivo cuando los científicos que operan el Telescopio del Horizonte de Sucesos —una colaboración de radiotelescopios de todo el mundo— apuntaron sus lentes al agujero negro que hay en el centro de la galaxia M87. Esto dio como resultado la primera imagen de la historia de un agujero negro, o más concretamente, la sombra que proyecta un agujero negro sobre las cosas que hay detrás de él. Aunque los investigadores han visto durante mucho tiempo pruebas de la existencia de estos objetos capaces de deformar el espacio-tiempo, por fín pudieron observar directamente uno de ellos. Los científicos esperan que este descubrimiento sea el comienzo de una nueva era para los agujeros negros y que les ayude a comprender mejor los chorros enormes de materia que arrojan los agujeros negros supermasivos.

Foto: National Science Foundation via Getty Images

La física en el mundo real

Quizás un héroe olvidado de la astrofísica y de la física de partículas de esta década es el uso de algoritmos de aprendizaje automático para clasificar grandes conjuntos de datos. La imagen del agujero negro no existiría sin el aprendizaje automático, y durante esta década su uso en la física de partículas está suponiendo un “punto de inflexión”, dijo Toro a Gizmodo.

Esta década también fue el comienzo de la tecnología basada en las peculiaridades de la física de partículas, como las computadoras cuánticas. “Creo que esta década es definitivamente aquella en la que las computadorascuánticas pasaron de la ciencia ficción a algo real”, dijo a Gizmodo Peter Shor, matemático del MIT.

Foto: Misha Friedman (Getty)

Richard Feynman propuso estos dispositivos cuánticos en 1981. Estos dispositivos pretenden resolver ciertos problemas que las computadoras normales no pueden, utilizando una especie de sistema de probabilidades de los átomos en vez de usando la lógica normal. Concretamente, los científicos esperan que algún día puedan simular el comportamiento de las moléculas o ejecutar ciertos algoritmos complejos utilizando nuevos trucos matemáticos. Básicamente, es como si hiciese distribuciones de probabilidad lanzando monedas al aire, solo que a diferencia de las reglas de probabilidad habituales, las probabilidades cuánticas pueden tener signos negativos cuando juntamos las “monedas”, lo que lleva a distribuciones de probabilidad más complejas que con las monedas que lanzamos de forma normal.

Fue en 2007 cuando los físicos de Yale inventaron el “qubit transmon”, un bucle de cable superconductor que actúa como un átomo artificial y que se convirtió en la unidad más pequeña de computación cuántica. Hoy, IBM y Google han desarrollado máquinas de más de 50 qubits que están comenzando a demostrar que quizás puedan solventar problemas que las computadoras clásicas no son capaces de abordar. También ha crecido todo un ecosistema de startups que ofrecen herramientas de software o hardware para estas máquinas.

Pueden pasar décadas antes de que estas máquinas ofrezcan ventajas sobre las computadoras clásicas además de actuar como generadores de números aleatorios. Son increíblemente difíciles de controlar sin que pierdan su estado cuántico debido a las vibraciones o la radiación del mundo exterior, lo cual puede provocar que muestren resultados incorrectos. Los investigadores ahora están trabajando para mejorar la corrección de estos errores, combinando múltiples qubits para crear un mega qubit “lógico” que no sea tan propenso a ello.

Pero los físicos esperan poder encontrar un uso para estos pequeños y ruidosos dispositivos. En 2017, el físico John Preskill declaró que habíamos entrado en una nueva era de la computación cuántica.

En esta década, los científicos también han incorporado las rarezas de la mecánica cuántica a nuevas tecnologías de detección, y científicos chinos lanzaron un satélite que utilizaba esta tecnología para encriptar sus mensajes. Trasladando lo cuántico a la ciencia de los materiales, los investigadores pueden haber creado el primer material capaz de conducir la electricidad sin resistencia a casi temperatura ambiente, otro descubrimiento que ha llevado décadas. Y el año pasado, los científicos descubrieron que podían activar y desactivar la superconductividad de dos láminas de grafeno con solo un giro, un descubrimiento que ha generado un montón de trabajos sobre sistemas bidimensionales.

La década de 2010 podría no ser el mejor momento en la historia de la física. A principios del siglo XX hubo docenas de nuevos descubrimientos, muchos de los cuales cambiaron por completo la forma en que los científicos pensaban sobre el universo a gran y pequeña escala. Tampoco ha sido una década de grandes sorpresas, y muchos de sus descubrimientos llevaron muchos años de trabajo. Pero es innegable que los historiadores que miren hacia atrás a esta década verán cambios de paradigma en toda la física, incluidas las nuevas tecnologías, los métodos experimentales y las formas de pensar que cambiaron el curso de la historia.

McBride afirmó: “Creo que ha sido una gran década para la física”.

Be the first to comment